وكتبت الشركة: تقتصر هذه التكنولوجيا على اكتشاف مواد الاعتداء الجنسي على الأطفال (CSAM) المخزنة في آيكلاود، ولن نوافق على أي طلب حكومي لتوسيعها.

ميزتان للحماية

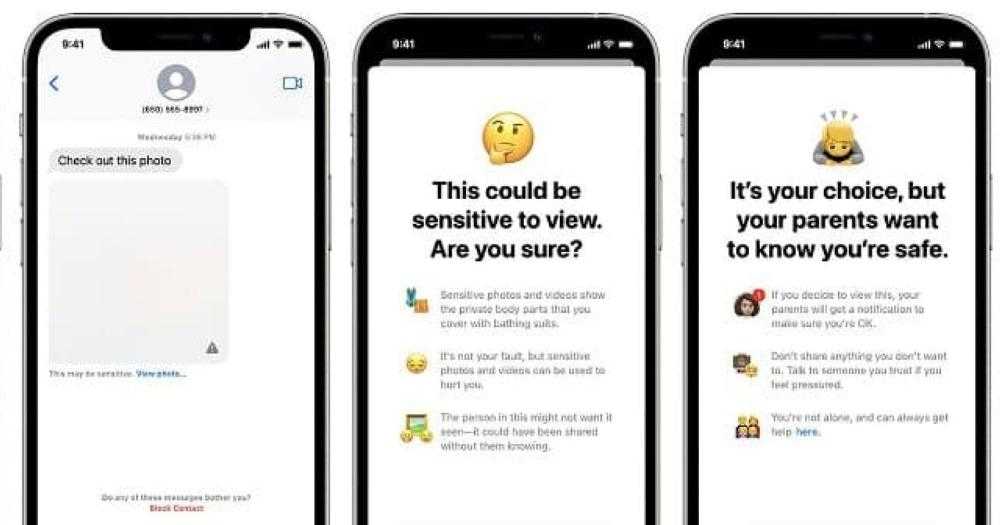

تشتمل أدوات الشركة الجديدة على ميزتين مصممتين لحماية الأطفال، الأولى: ميزة أمان الاتصال التي تستخدم التعلم الآلي عبر الجهاز في تحديد وتمويه الصور الجنسية الصريحة التي يتلقاها الأطفال في تطبيق الرسائل، ويمكنها إخطار أحد الوالدين إذا قرر طفل يبلغ من العمر 12 عاما أو أصغر عرض هذه الصورة أو إرسالها.

الثانية: ميزة مصممة لاكتشاف مواد الاعتداء الجنسي على الأطفال عن طريق مسح صور المستخدمين إذا اختاروا تحميلها عبر آيكلاود، ويتم إخطار الشركة إذا تم اكتشاف مواد الاعتداء الجنسي على الأطفال، التي بدورها تنبه السلطات عندما تتحقق من وجود هذه المواد.

قوبلت الخطط برد فعل عنيف سريع من مجموعات الخصوصية الرقمية والناشطين الذين جادلوا بأنها ستوفر بابًا خلفيًا في برامج الشركة.

مواد معارضة

تشير هذه المجموعات إلى أنه فور وجود مثل هذا الباب الخلفي، يكون هناك دائمًا احتمال توسيعه، للبحث عن أنواع المحتوى التي تتجاوز مواد الاعتداء الجنسي على الأطفال.

ويمكن للحكومات الاستبدادية استخدام هذا الباب في البحث عن مواد المعارضة السياسية، إذ كتبت مؤسسة «الحدود» الإلكترونية: حتى الباب الخلفي الموثق بدقة والمدروس بعناية والضيق النطاق لا يزال بابًا خلفيًا.

وأضافت: تمت إعادة توظيف إحدى التقنيات، التي تم إنشاؤها في الأصل لفحص صور الاعتداء الجنسي على الأطفال وتجزئتها، لإنشاء قاعدة بيانات للمحتوى الإرهابي الذي يمكن للشركات المساهمة فيها والوصول إليها بغرض حظر مثل هذا المحتوى.

ومع ذلك، تجادل الشركة المصنعة لهواتف «آيفون» بأن لديها ضمانات لمنع استخدام أنظمتها في اكتشاف أي شيء آخر غير صور الاعتداء الجنسي.